Conteúdo

Anthropic muda política: seus dados poderão treinar a IA Claude

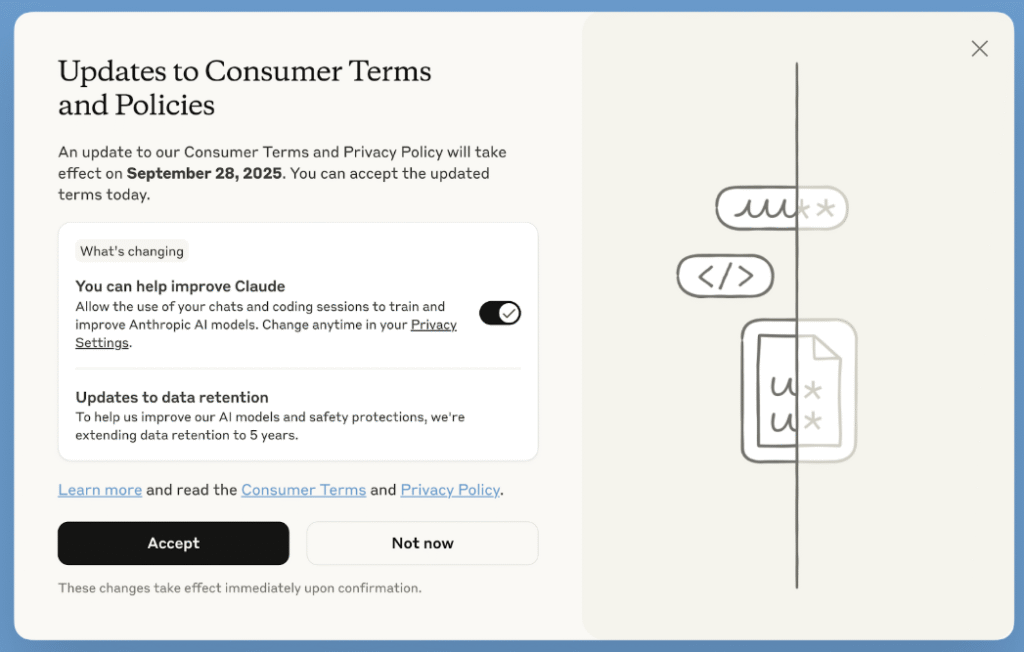

A Anthropic anunciou que começará a treinar seus modelos de IA com dados dos usuários, incluindo novas conversas e sessões de código, a menos que você opte por não participar (opt-out). Além disso, a empresa ampliou sua política de retenção de dados para cinco anos para quem não desativar essa opção.

Quem é a Anthropic?

A Anthropic é uma empresa de inteligência artificial fundada por ex-funcionários da OpenAI, focada no desenvolvimento de modelos de linguagem avançados com forte ênfase em segurança, ética e interpretabilidade. Seu principal produto é o Claude, uma família de modelos de IA que compete com soluções como ChatGPT e Gemini. A missão da Anthropic é criar sistemas de IA que sejam seguros, transparentes e alinhados aos interesses humanos.

O que será usado para treino?

A nova configuração se aplica a:

✔ Novos chats ou sessões de código

✔ Chats antigos retomados (se você continuar uma conversa antiga, ela poderá ser usada)

❌ Não se aplica a planos comerciais, como Claude Gov, Claude for Work, Claude for Education e uso via API (Amazon Bedrock, Google Cloud Vertex AI).

Como será apresentado ao usuário?

A mudança será exibida por meio de um pop-up com o título:

“Updates to Consumer Terms and Policies”

Abaixo, haverá a frase:

“Allow the use of your chats and coding sessions to train and improve Anthropic AI models”, com um botão grande “Accept” e um toggle (On/Off) que, por padrão, estará ativado (On).

💡 Risco: muitos usuários podem clicar em “Accept” sem ler os detalhes e sem desativar a opção.

Como optar por NÃO participar?

Para manter sua privacidade:

- No pop-up, desative o toggle para “Off” antes de clicar em Accept.

- Se já aceitou por engano, vá em:

Configurações → Privacidade → Configurações de Privacidade → “Help improve Claude” → Off.

📌 Importante: a mudança só vale para dados futuros. Tudo que já foi usado para treino não pode ser desfeito.

Privacidade e segurança

Segundo a Anthropic:

- Eles não vendem dados para terceiros.

- Usam ferramentas e processos automáticos para filtrar ou ocultar dados sensíveis.

Ainda assim, a retenção de até 5 anos levanta discussões sobre privacidade e controle de dados.

Prazo para decisão

Todos os usuários deverão escolher até 28 de setembro de 2025.

- Quem clicar em “Aceitar” agora autorizará imediatamente o uso dos dados para treinar a IA e permitirá que eles sejam mantidos por até cinco anos.

- Essa atualização vale para todos os planos de consumo do Claude (Free, Pro e Max), incluindo o Claude Code.

Conclusão

Essa mudança reforça um ponto crucial: entender políticas de privacidade antes de clicar em “Aceitar”. Se você é usuário do Claude e não quer que suas conversas sejam usadas para treinar IA, é essencial desativar a opção no pop-up ou nas configurações.